Une commission d'enquête a été organisée sur les coûts du nucléaire, avec pour rapporteur Denis Baupin, bien connu pour son opposition à cette technologie. Une commission au thème extraordinairement similaire avait été organisée au Sénat, il y a deux ans. Le résultat relevait de la la pure idéologie écologiste, s'appuyant sur des tactiques d'enfumage et n'hésitant pas à pousser le scénario où il y avait le plus d'énergies fossiles. Vue l'identité du rapporteur, on pouvait craindre une redite et on n'a pas été déçu.

Quelques mots d'abord sur le style: le rapport semble constitué principalement de citations extraites des auditions de la commission, entrecoupés par le texte du rapporteur. Il compte relativement peu de tableaux et de données comparé au rapport de la commission sénatoriale d'il y a 2 ans. On en est donc réduit à devoir faire confiance — ou pas — aux choix de Denis Baupin pour ses citations et le sens qu'il veut bien leur donner. En effet, dans la masse de propos tenus, il est certainement possible de choisir les citations pour écrire soit un rapport chantant les louanges du nucléaire, soit un rapport vouant cette technique aux gémonies. Pour savoir quelle option a été choisie, on peut se référer au passage sur le scénario énergétique qui a la préférence de Denis Baupin et regarder si l'objectivité est au rendez-vous.

Avant d'aborder le scénario qui a sa préférence, Denis Baupin a expédié le scénario prôné par EDF, certes peu crédible mais qui a le mérite pour ses dirigeants de ne pas aller frontalement à l'encontre de l'opinion proclamée de la tutelle politique. Pour le dire autrement, Denis Baupin écrit que ce scénario n'est pas probable. Et c'est donc tout naturellement qu'il titre:

B. APPROCHE 2 : UNE BAISSE DE LA DEMANDE ÉNERGÉTIQUE EST POSSIBLE, CE QUI REND INUTILE LA PROLONGATION DE L’ENSEMBLE DU PARC NUCLÉAIRE

Comme on va le voir, ce scénario n'est pas plus probable à l'heure actuelle que celui d'EDF. Autrement dit, n'ont droit à des développements que des scénarios possibles mais aucun de ceux qui apparaissent comme les plus probables. Après avoir cité un intervenant se prévalant de pouvoir déterminer le service attendu et les besoins

ainsi que les consommations superfétatoires ou le gaspillage

, comme au bon vieux temps du Gosplan, et un autre intervenant déplorant le faible nombre de rapports sur les économies d'énergie comparé aux rapports sur le nucléaire — tout en cherchant à démontrer sur son site l'inutilité des réacteurs nucléaires, on passe aux choses sérieuses et on aborde le fameux exemple allemand.

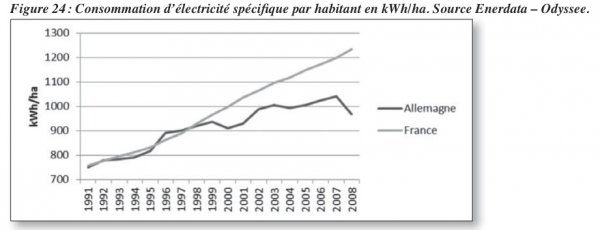

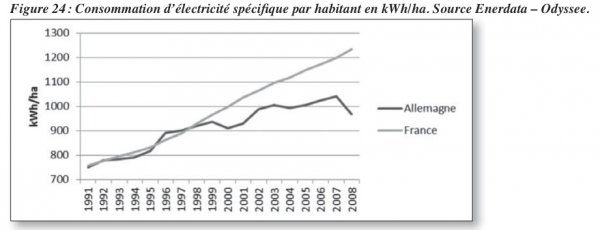

L’exemple allemand montre qu’une forte diminution de la consommation est possible si l’on met en place les instruments adéquats. Une étude comparative des systèmes énergétiques français et allemand publiée en 2011 par l’IDDRI et l’association Global Chance a montré que la consommation d’électricité « spécifique » – incluant les appareils électriques et l’éclairage, mais excluant le chauffage et le chauffe-eau – par habitant était au même niveau dans les deux pays en 1998. À cette date est instaurée une taxe écologique sur l’électricité dont les recettes sont affectées à l’abaissement des charges sociales sur le travail. L’Allemagne a ensuite connu une augmentation régulière des tarifs de l’électricité, liée à plusieurs effets, aboutissant à un prix du kilowattheure de 27 centimes. « À partir de 2000, l’Allemagne commence à stabiliser sa consommation d’électricité spécifique par habitant dans le logement, tandis que la courbe de la consommation française continue d’évoluer de façon quasi linéaire. En 2010, la différence de la consommation par habitant est de 15 % et de 27 % par ménage … Fixer un objectif raisonnable d’économie de l’ordre de 15 % n’a donc rien de scandaleux » (Bernard Laponche).

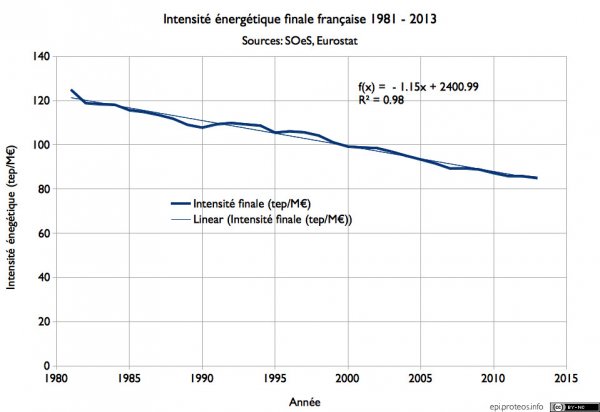

Pour voir si tout ceci est à la hauteur des enjeux, regardons l'étude en question (p69-70) où on trouve le graphe suivant:

Comme le signalent les auteurs eux-mêmes, ces chiffres n'ont pas le même degré de fiabilité que les autres indicateurs utilisés dans cet article. D’autre part, on constate en Allemagne des variations parfois importantes d’une année sur l’autre alors que la consommation d’électricité spécifique est peu soumise à des variations climatiques. Il est difficile d’expliquer les renversements de tendance observés dans le cas de l’Allemagne et il faut prendre les statistiques concernant les consommations d’électricité spécifique avec prudence.

Regardons toutefois l'impact d'une diminution de 15% de la consommation d'électricité spécifique française telle qu'elle nous est présentée. En France, il y environ 65M d'habitants, une consommation de 1200kWh par an et par habitant représente donc une consommation totale annuelle de 78TWh. En 2008, selon Eurostat, la consommation totale d'électricité en France a été d'un peu moins de 433TWh. La consommation d'électricité spécifique par les ménages représente donc un peu moins de 20% de la consommation totale d'électricité. Une réduction de 15% de cette consommation représenterait donc une baisse de 3% de la consommation totale d'électricité. Même si c'était jusqu'alors un des postes de consommation les plus dynamiques en France, cela semble très insuffisant pour obtenir une forte baisse de la consommation d'électricité.

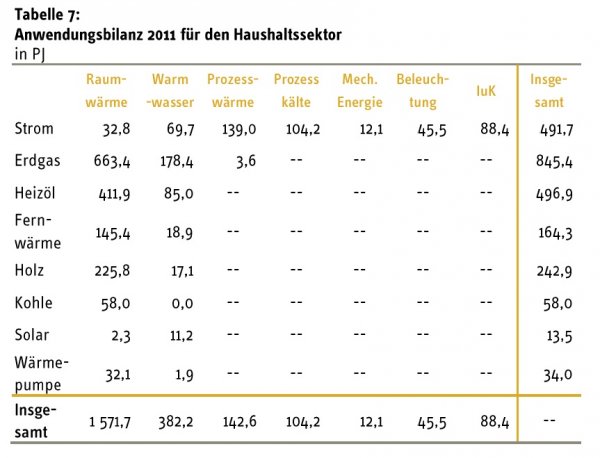

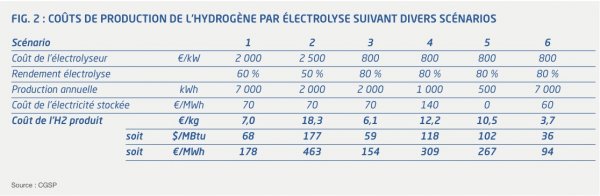

On peut aussi se demander si les données sur lesquelles se fonde Global Chance reflètent bien la réalité. Sur le site de l'association AG Energibilanzen, on peut trouver un document détaillant les consommations énergétiques des ménages. On y trouve ce tableau (p20) qui résume l'ensemble, où la consommation d'électricité spécifique est donnée par la somme des 5 dernières colonnes.

On voit que la consommation d'électricité spécifique est de 389.2 PJ annuels; avec une population allemande d'environ 82M d'habitants, cela donne environ 1300kWh par an et par habitant. On peut constater que c'est tout à fait comparable à la consommation française. Ce n'est pas très étonnant: dans ce domaine la consommation est déterminée par les standards appliqués aux appareils électriques, comme le montre l'exemple des États-Unis. Or, ces standards sont déterminés au niveau européen et sont de ce fait les mêmes pour la France et l'Allemagne.

On voit que la consommation d'électricité spécifique est de 389.2 PJ annuels; avec une population allemande d'environ 82M d'habitants, cela donne environ 1300kWh par an et par habitant. On peut constater que c'est tout à fait comparable à la consommation française. Ce n'est pas très étonnant: dans ce domaine la consommation est déterminée par les standards appliqués aux appareils électriques, comme le montre l'exemple des États-Unis. Or, ces standards sont déterminés au niveau européen et sont de ce fait les mêmes pour la France et l'Allemagne.

Cette conclusion est d'ailleurs assez logique: en Allemagne, la quasi absence du chauffage électrique fait que l'essentiel de l'électricité consommée par les ménages est de l'électricité spécifique. Les données de l'AGEB montrent que la consommation des ménages par personne en 2011 était d'environ 1670kWh (ce qui est cohérent avec les données d'Eurostat). Autrement dit, les ordres de grandeur ne collent pas avec le graphe de Global Chance.

Denis Baupin enchaîne:

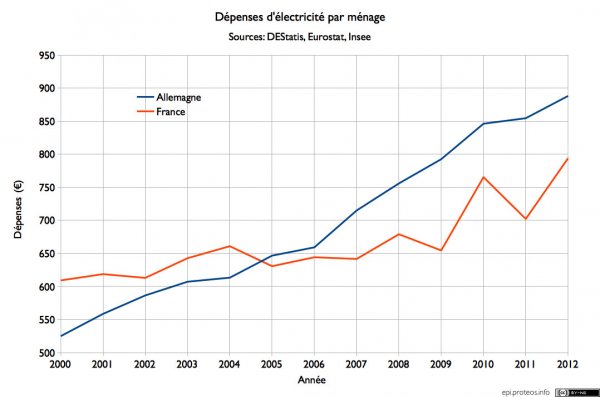

À l’arrivée, le ménage allemand paie son kWh électrique plus cher que le ménage français, mais en consomme moins, ce qui conduit à des factures du même niveau de part et d’autre du Rhin. À l’occasion du débat sur la transition énergétique (DNTE) le rapport adopté par le groupe de travail « compétitivité » avait d’ailleurs montré que la part des revenus consacrés par les ménages français et allemands à leur éclairage et à leur chauffage était exactement la même : 4,8 %.

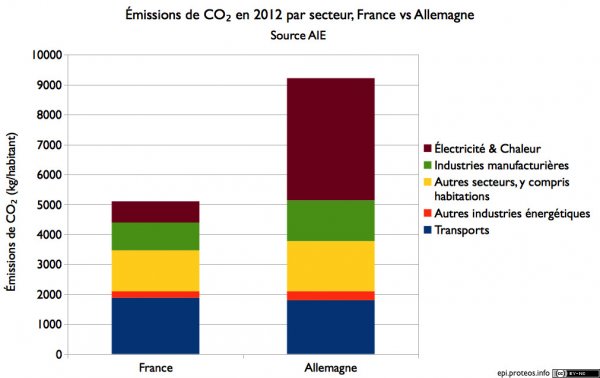

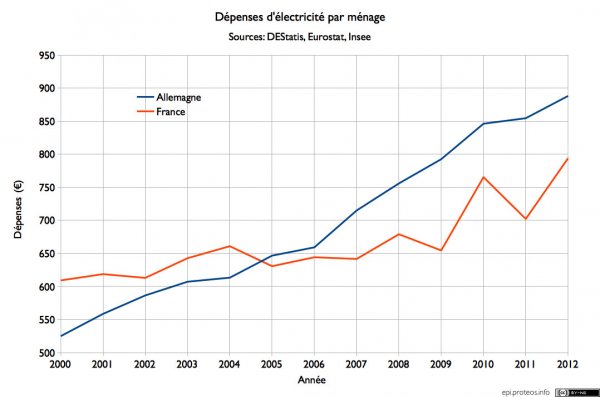

La première affirmation est totalement fausse. Tellement que, devant la commission sénatoriale, Global Chance avait reconnu que les Allemands payaient plus par habitant que les Français. Certes, les ménages français comptent en moyenne plus de membres, mais cela ne suffit pas à combler la différence. On peut même se référer aux organismes statistiques habituels pour récupérer les données et obtenir le graphe suivant:

On constate que l'état des choses s'est inversé entre le début des années 2000 et aujourd'hui. À cause de la forte hausse des prix de l'électricité en Allemagne, les ménages allemands ont vu leur facture pratiquement doubler. Cela a fait plus qu'effacer la différence de dépense qui existait jusque là à leur avantage du fait de la plus forte consommation française. En 2012, année froide et donc de forte consommation d'électricité par les ménages, un ménage français a consommé en moyenne presque 5600kWh alors qu'un ménage allemand n'a consommé que 3370kWh. Un tel développement montre surtout que l'électricité est un bien dont l'élasticité prix à court et moyen terme est très faible: même une forte hausse du prix ne suscite qu'une faible baisse de la consommation. Dans ces conditions, la hausse du prix se traduit directement par une hausse presque équivalente de la dépense.

On constate que l'état des choses s'est inversé entre le début des années 2000 et aujourd'hui. À cause de la forte hausse des prix de l'électricité en Allemagne, les ménages allemands ont vu leur facture pratiquement doubler. Cela a fait plus qu'effacer la différence de dépense qui existait jusque là à leur avantage du fait de la plus forte consommation française. En 2012, année froide et donc de forte consommation d'électricité par les ménages, un ménage français a consommé en moyenne presque 5600kWh alors qu'un ménage allemand n'a consommé que 3370kWh. Un tel développement montre surtout que l'électricité est un bien dont l'élasticité prix à court et moyen terme est très faible: même une forte hausse du prix ne suscite qu'une faible baisse de la consommation. Dans ces conditions, la hausse du prix se traduit directement par une hausse presque équivalente de la dépense.

Quant à la deuxième affirmation, elle n'a que peu à voir avec l'électricité. D'une part, en Allemagne, l'électricité est très peu utilisée pour le chauffage et comme on peut le constater sur la décomposition des consommations d'énergie, ce sont le gaz et le pétrole qui représentent l'essentiel des quantités consommées pour l'éclairage et le chauffage. De même, en France, l'inclusion du chauffage donne une place importante à d'autres vecteurs d'énergie que l'électricité. Une telle donnée relève donc de l'enfumage.

Après quelques considérations sur les travaux qui permettent de faire des économies d'énergie mais sans aucune considération pour les coûts de ces travaux qui les rendent non rentables aux prix actuels de l'énergie, Denis Baupin passe à l'accusé habituel des écologistes: le chauffage électrique.

3. Limiter l’utilisation de l’électricité à ses usages « nobles » ?

Les progrès de l’efficacité énergétique permettent de diminuer la consommation électrique et ouvrent ainsi une voie vers la réduction de la dimension du parc nucléaire français. Ils permettent également de corriger les défauts du système électrique français actuel, marqué par gaspillages significatifs.

D’une part, le rendement thermique des centrales nucléaire, d’environ un tiers, est très bas en comparaison des autres moyens de production. « Dans la production nucléaire actuelle, le volume d’énergie lié au rendement des centrales, sous forme de chaleur, est perdu. Il représente 830 milliards de kilowattheures, soit plus que le chauffage de tous les logements et les bâtiments tertiaires de France » (Thierry Salomon).

Cet argument est habituel chez les écologistes. Il consiste à constater que la transformation de la chaleur en travail a forcément une efficacité inférieure à 100%, sévèrement limitée par le second principe de la thermodynamique. Cependant, ceci n'a pas forcément d'importance pour les consommateurs: cette efficacité n'est qu'un des composants du coût de l'électricité et ne dit rien de la pollution engendrée. Faisons une expérience de pensée: une source d'énergie permet de produire de l’électricité très peu chère et très peu polluante mais via un procédé qui n'utilise qu'une faible part de l'énergie disponible. Faut-il s'en priver pour cette dernière raison? La réponse est clairement non.

L'électricité nucléaire a pour caractéristique d'être peu sensible au prix de l'uranium et donc à l'efficacité de conversion de la chaleur en électricité, contrairement à ses concurrents le gaz et, dans une mesure un peu moindre, le charbon. Ceux-ci sont aussi tenus par des normes anti-pollution qui rendent attractives une moindre consommation de combustible. C'est ainsi que ses sont développées les centrales à gaz à cycle combiné — qui atteignent 60% d'efficacité — et les centrales super-critiques au charbon — qui dépassent les 40%. Ces efforts sont cependant insuffisants lorsqu'on considère les problèmes climatique et d'effet de serre, par exemple.

On peut aussi constater que d'autres procédés sont comptés comme ayant une efficacité de 100%, mais uniquement parce qu'ils utilisent une source qui n'est pas directement payante. Ainsi, l'énergie éolienne a une limite physique de 60% pour la récupération du flux d'air, dont la technique permet de récupérer les trois quarts pour une efficacité de l'ordre de 45%. Les cellules photovoltaïques commercialisées ont un rendement de conversion compris entre 5% et 20%. Cela n'en fait pas pour autant un mauvais mode de production d'électricité.

D’autre part, l’utilisation massive des chauffages électriques explique que la pointe électrique française soit sans commune mesure avec celle des autres pays européens, la Norvège exceptée. « Notre scénario prévoit, par ailleurs, un glissement vers beaucoup moins de chauffage à effet Joule, qui est le problème du réseau actuel. RTE, qui vient de refaire ses calculs, a évalué la sensibilité électrotechnique à 2 400 MW par degré : autrement dit, à chaque fois qu’en hiver la température baisse d’un degré en France, il nous faut mettre en marche deux réacteurs et demi de 900 MW. Vous savez que cette sensibilité électrotechnique est une malheureuse caractéristique française : nous avons la moitié de la sensibilité électrotechnique de l’Europe. Si on baisse cette valeur-là par une politique d’efficacité énergétique, de transfert vers des usages beaucoup nobles de l’électricité et vers d’autres énergies, on retrouvera une marge de manœuvre. Dans notre scénario, nous redescendons cette consommation maximale sur l’ensemble du réseau aux alentours de 60/70 GW, donc bien en dessous des records que vous connaissez, qui sont à 110 GW » (Thierry Salomon).

Les caractéristiques françaises du mix électrique ne sont donc pas si favorables qu’annoncées, dans la mesure où l’importance de la pointe électrique requiert la mise en marche de moyens de production thermiques fortement émetteurs de gaz à effet de serre.

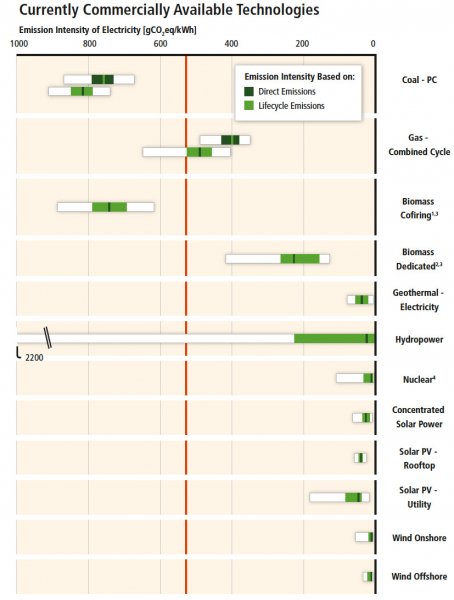

Mezzo voce, Denis Baupin tente d'accréditer l'idée que le chauffage électrique est plus polluant que les autres options. Comme je l'avais remarqué, il n'en est rien, au contraire, le chauffage électrique provoque relativement peu d'émission de CO₂. J'avais estimé qu'il était responsable de 15% des émissions de CO₂ dus au chauffage des logements, alors que la part de marché du chauffage électrique est autour de 33%. Denis Baupin fait ici usage d'une technique bien connue qui consiste à insister sur des évènements relativement rares — les pointes de demande — pour ignorer la situation moyenne. Cette situation moyenne est forcément bonne, puisque les émissions globales du système électrique français sont parmi les plus basses au monde rapportées à la production.

On peut certes souhaiter que les pompes à chaleur se développent: elles permettent déjà que le chauffage électrique soit pratiquement imbattable en termes d'émissions rapporté au service rendu. Cependant, cela ne dit rien quant à la proportion d'énergie nucléaire souhaitable. Après tout, les écologistes disent que c'est le chauffage électrique qui force à conserver nombre de centrales à combustible fossile. Son déclin devrait donc plutôt entraîner la diminution de la part des énergies fossiles que celle du nucléaire.

La mise au point de business models pour l’efficacité énergétique, en s’inspirant par exemple des dispositifs existant chez nos voisins, constitue néanmoins aujourd’hui une priorité pour la réalisation d’objectifs volontaristes. La réflexion devra aboutir rapidement afin d’accélérer la maîtrise de la consommation énergétique et notamment un rythme de rénovations thermiques encore loin d’être suffisant. À défaut, il pourrait être tentant de présenter la prolongation de tout le parc nucléaire comme une option qui s’imposerait. Ce serait toutefois une solution de facilité qui priverait la France d’une véritable transition énergétique. Le jeu en vaut pourtant la chandelle tant les scénarios produisent des effets très positifs sur l’emploi.

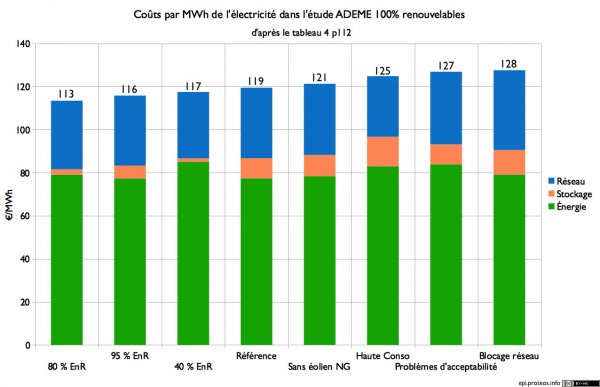

Malheureusement pour Denis Baupin, il y a peu de rénovations par rapport à ses espérances parce que les prix de l'énergie ne sont pas assez élevés. Pour en avoir plus, il faudrait augmenter fortement le prix de l'énergie en France — et pas seulement de l'électricité! — ce qui fait qu'au total, les Français dépenseraient plus. Non seulement, ils paieraient plus cher pour leur électricité — et le reste — comme le montre l'exemple allemand, mais ils devraient aussi payer ces fameuses rénovations.

On ne peut aussi que se demander ce que Denis Baupin compte faire des 33% de logements chauffés à l'électricité. Ces logements n'ont souvent aucune arrivée de gaz, l'électricité est donc la seule façon de les chauffer, à moins d'engager des dépenses pharaoniques. De plus, comme on l'a vu, ils provoquent relativement peu de pollution, notamment d'émissions de CO₂. Proposer un état final qui lui paraît favorable est une chose, encore faudrait-il proposer une façon réaliste d'aller de la situation actuelle à cet état final. C'est pourquoi il n'est pas sérieux de présenter comme probables des scénarios où le chauffage électrique n'existerait plus; au contraire, la consommation d'électricité par habitant en France restera durablement plus élevée qu'ailleurs.

Bref, Denis Baupin fait reposer son plaidoyer pour le scénario qui a sa préférence sur des faux-semblants voire des mensonges, ignore totalement la situation actuelle et les difficultés pour parvenir à la situation qui a sa préférence. Le reste de son rapport est peut-être excellent, mais sa justification du scénario qui a sa préférence laisse plutôt penser que c'est une redite de la commission d'enquête sénatoriale d'il y a 2 ans, en pire!

Derniers commentaires